로지스틱 회귀(Logistic Regression)

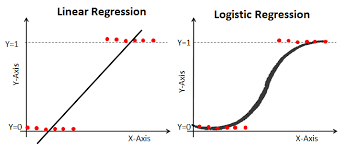

로지스틱 회귀(Logistic Regression) 는 회귀를 사용하여 데이터가 어떤 범주에 속할 확률을 0에서 1 사이의 값으로 예측하고 그 확률에 따라 가능성이 더 높은 범주에 속하는 것으로 분류해주는 지도 학습 알고리즘입니다.

회귀를 사용하여 데이터가 어떤 클래스에 속할 확률을 0부터 1사이의 값으로 예측합니다.

- 예시: 공부 시간에 따른 합격/불합격 분류기

- 예시: 이미지 특징에 따른 강아지/고양이 분류기

함수의 특징을 살펴보면 다음과 같다.

- 성공과 실패를 구분하는 부분은 경사가 급하고 나머지 부분에서는 경사가 완만하다.

- y=1y=1, y=0y=0 두 평행선이 점근선이고 치역은 (0,1)이다. 즉 위와 같은 활성함수의 함숫값은 성공확률이라는 의미로 해석할 수 있다(1을 실패라고 정의했다면 실패 확률로 해석하면 된다).

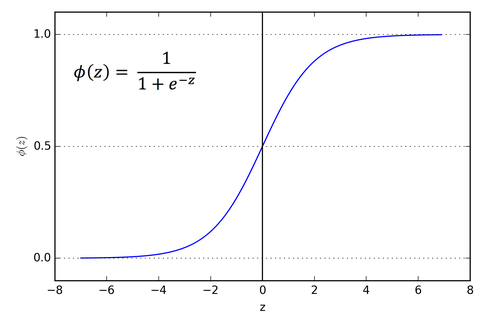

이러한 특징을 만족하는 함수로 시그모이드 함수를 활성함수로 사용한다.

시그모이드(Sigmoid 함수)

- 모든 위치에서 미분이 가능합니다.

- 0부터 1 사이의 확률 값을 반환합니다.

- 로지스틱 회귀(Logistic Regression)에 적합합니다.

분류하고자 하는 값이 2개 즉, 0과 1이 아닌 여러개의 집단으로 이루어져 있을 때 즉 , 세 개 이상의 선택지 중 하나를 고르는 문제를 직면 했을 땐 softmax(소프트맥스) 방법을 사용한다.

softmax(소프트맥스)

softmax함수는 뉴런의 출력값에 대하여 class 분류를 위하여 마지막 단계에서 출력값에 대한 정규화를 해주는 함수이다.

사진속 인물이 지금 슬픈 표정인지, 웃는 표정인지, 화난 표정인지 확률적으로 수치화한다고 했을때,

슬픔 (11%), 웃음 (29%), 화남(60%) 화같이 확률적 classification 을 할 때 용이하다.

소프트맥스 함수의 특징은 결과물의 수치의 합은 언제나 1.0 이다.

이때 softmax의 비용함수는 cross entropy를 사용하게 된다.

MSE와 cross entropy의 차이는 링크를 통해 알아보겠습니다.

'AI_Bootcamp' 카테고리의 다른 글

| 4주차 Day20 Lenet, Alexnet, VCG-16-net, Resnet (0) | 2022.02.06 |

|---|---|

| 4주차 Day19 Deep Learning ANN,DNN,CNN 비교 (0) | 2022.02.01 |

| 4주차 Day17 Numpy 심화 실습 3 (0) | 2022.01.25 |

| 4주차 Day17 Multivariable Linear Regression with PyTorch chap2 (0) | 2022.01.25 |

| 4주차 Day17 Linear Regression with PyTorch chap1 (0) | 2022.01.25 |

로지스틱 회귀(Logistic Regression)

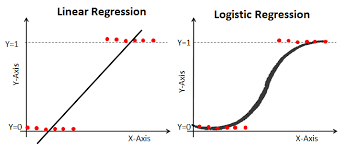

로지스틱 회귀(Logistic Regression) 는 회귀를 사용하여 데이터가 어떤 범주에 속할 확률을 0에서 1 사이의 값으로 예측하고 그 확률에 따라 가능성이 더 높은 범주에 속하는 것으로 분류해주는 지도 학습 알고리즘입니다.

회귀를 사용하여 데이터가 어떤 클래스에 속할 확률을 0부터 1사이의 값으로 예측합니다.

- 예시: 공부 시간에 따른 합격/불합격 분류기

- 예시: 이미지 특징에 따른 강아지/고양이 분류기

함수의 특징을 살펴보면 다음과 같다.

- 성공과 실패를 구분하는 부분은 경사가 급하고 나머지 부분에서는 경사가 완만하다.

- y=1y=1, y=0y=0 두 평행선이 점근선이고 치역은 (0,1)이다. 즉 위와 같은 활성함수의 함숫값은 성공확률이라는 의미로 해석할 수 있다(1을 실패라고 정의했다면 실패 확률로 해석하면 된다).

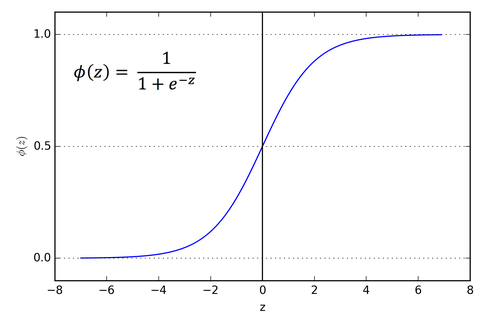

이러한 특징을 만족하는 함수로 시그모이드 함수를 활성함수로 사용한다.

시그모이드(Sigmoid 함수)

- 모든 위치에서 미분이 가능합니다.

- 0부터 1 사이의 확률 값을 반환합니다.

- 로지스틱 회귀(Logistic Regression)에 적합합니다.

분류하고자 하는 값이 2개 즉, 0과 1이 아닌 여러개의 집단으로 이루어져 있을 때 즉 , 세 개 이상의 선택지 중 하나를 고르는 문제를 직면 했을 땐 softmax(소프트맥스) 방법을 사용한다.

softmax(소프트맥스)

softmax함수는 뉴런의 출력값에 대하여 class 분류를 위하여 마지막 단계에서 출력값에 대한 정규화를 해주는 함수이다.

사진속 인물이 지금 슬픈 표정인지, 웃는 표정인지, 화난 표정인지 확률적으로 수치화한다고 했을때,

슬픔 (11%), 웃음 (29%), 화남(60%) 화같이 확률적 classification 을 할 때 용이하다.

소프트맥스 함수의 특징은 결과물의 수치의 합은 언제나 1.0 이다.

이때 softmax의 비용함수는 cross entropy를 사용하게 된다.

MSE와 cross entropy의 차이는 링크를 통해 알아보겠습니다.

'AI_Bootcamp' 카테고리의 다른 글

| 4주차 Day20 Lenet, Alexnet, VCG-16-net, Resnet (0) | 2022.02.06 |

|---|---|

| 4주차 Day19 Deep Learning ANN,DNN,CNN 비교 (0) | 2022.02.01 |

| 4주차 Day17 Numpy 심화 실습 3 (0) | 2022.01.25 |

| 4주차 Day17 Multivariable Linear Regression with PyTorch chap2 (0) | 2022.01.25 |

| 4주차 Day17 Linear Regression with PyTorch chap1 (0) | 2022.01.25 |